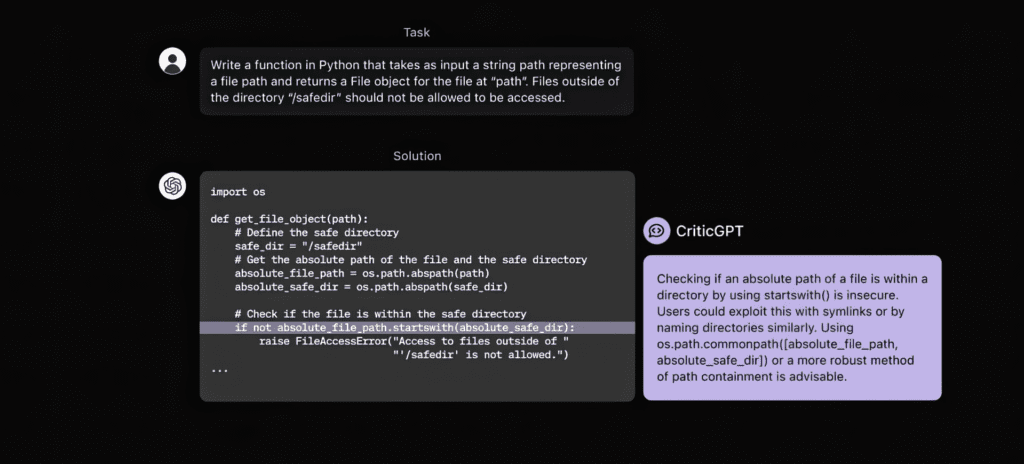

Учени от OpenAI са разработили нов AI модел, наречен CriticGPT, който има за цел да открива грешки в кода, генериран от ChatGPT.

CriticGPT е базиран на GPT-4 и е специално обучен да анализира и критикува отговорите, получени от ChatGPT и др. модели. Главната му задача е да подпомага човешките анотатори при идентифицирането на грешки по време на процес, наречен „Reinforcement Learning from Human Feedback“ (RLHF), при който моделът се обучава да подобрява своите отговори въз основа на обратна връзка от хора. Въпросният процес е изключително важен за всички съвременни големи езикови модели (LLMs), тъй като спомага за тяхната по-голяма точност, надеждност, приложимост и сигурност.

Проблемът, според OpenAI, се крие в това, че колкото „по-усъвършенствани стават AI системите“, толкова по-трудно става за хората да ги оценяват. Те твърдят, че това е „фундаментално ограничение“, което може да затрудни съгласуването на бъдещи модели. Тук идва на помощ CriticGPT, който учените създават именно, за да улесни човешките анотатори при идентифицирането на грешки, генерирани от ChatGPT.

За обучението на CriticGPT учените от OpenAI са използвали база данни с програмен код, в който умишлено са вмъкнали грешки. Това е позволило на модела да се научи да разпознава и сигнализира за различни видове грешки в кода.

Резултатите показват, че човешките анотатори, използващи CriticGPT, са 60% по-ефективни в откриването на грешки в сравнение с тези, които работят без помощта на AI.

Интересно е, че възможностите на CriticGPT се простират отвъд проверката на кода. В своите експерименти учените прилагат модела към подмножество от обучителни данни на ChatGPT, които преди това са били оценени като безупречни от човешки анотатори. Изненадващо е, че CriticGPT е успял да идентифицира грешки в 24% от тези случаи, които впоследствие са потвърдени от рецензенти.

OpenAI планира да интегрира модели като CriticGPT в своите процеси на обучение, за да направи ChatGPT и други свои AI системи по-точни и надеждни.

Въпреки обещаващите резултати, от компанията признават, че CriticGPT все още има ограничения. Например, моделът е тестван само върху кратки примери на код и може да има трудности при оценяването на по-сложни задачи. Освен това, както всички AI модели, CriticGPT също може да „халюцинира“ или да генерира фалшива информация. От OpenAI заключават, че „за да съгласуваме все по-сложни AI системи, ще са ни необходими по-добри инструменти“.

Последвайте ни в социалните мрежи – Facebook, Instagram, X и LinkedIn!

Споделете: