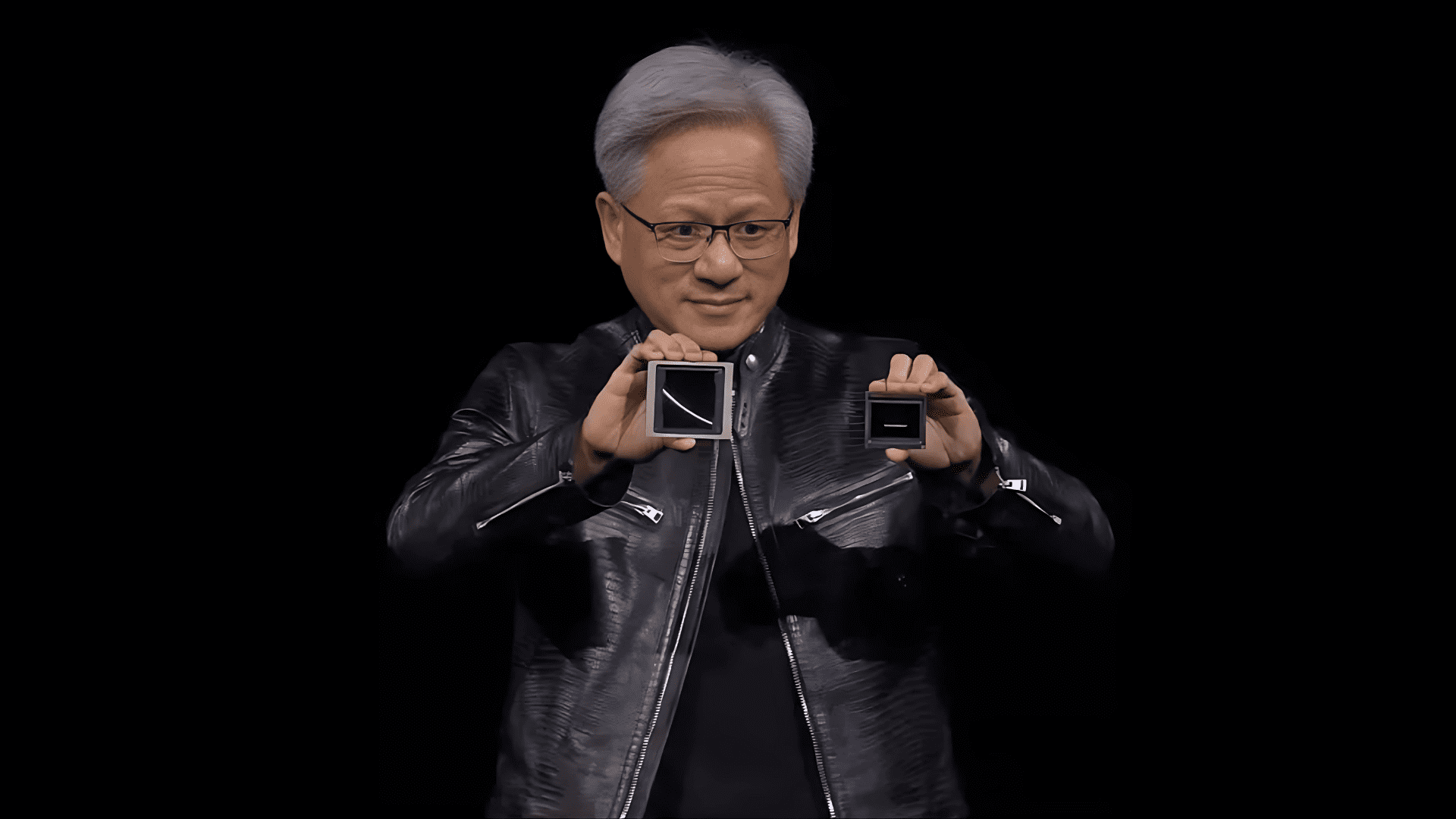

Вчера, по време на конференцията GPU Technology Conference (GTC), главният изпълнителен директор на NVIDIA, Дженсън Хуанг, обяви следващото поколение графични процесори на компанията – Blackwell. Носещи името на математика Дейвид Харолд Блекуел, те ще позволят на най-големите организации в света да разработват и внедряват генеративни AI модели с трилиони параметри.

В продължение на три десетилетия се стремим към ускорени изчисления, с цел да направим възможни трансформиращи пробиви като дълбокото обучение и изкуствения интелект

– заяви Дженсън Хуанг.

Генеративният изкуствен интелект е определящата технология на нашето време. Blackwell е двигателят, който ще захрани тази нова индустриална революция.

Blackwell е наследник на изключително популярните графични чипове H100 и H200, като според компанията това е най-мощният чип за изкуствен интелект в света. Серията включва B100 и B200, като вторият разполага с 208 милиарда транзистора и осигурява до 20 petaFLOPS производителност на FP4 AI, което е 5 пъти повече от предшественика му Hopper.

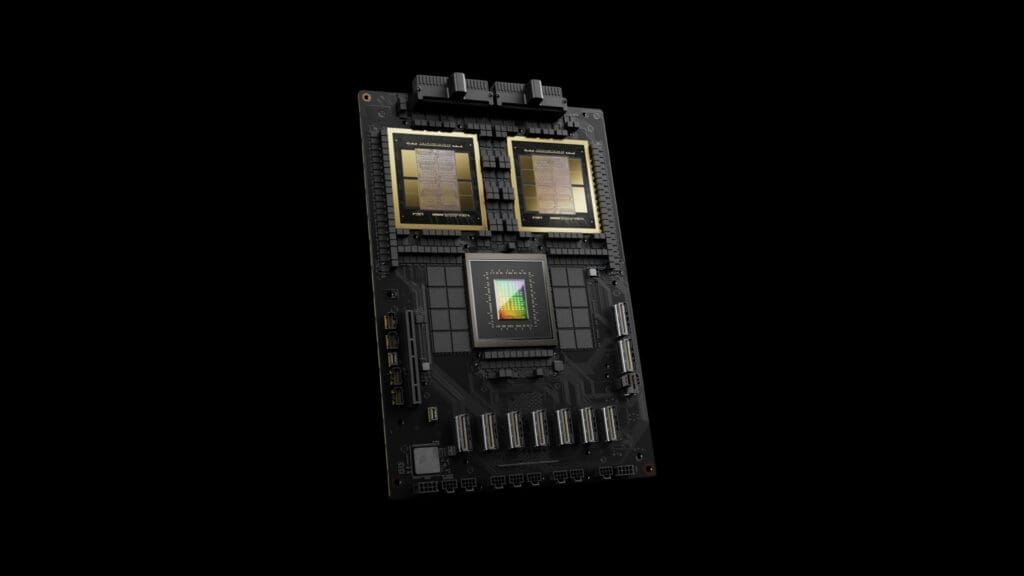

Подобно на Hopper, графичният процесор Blackwell ще се предлага като самостоятелен чип или два в комплект, свързани с процесора Grace на Nvidia, създавайки така наречения суперчип GB200 Grace Blackwell Superchip. Nvidia твърди се, че тази конфигурация осигурява до 30 пъти по-висока производителност от графичния процесор H100, като същевременно използва до 25 пъти по-малко енергия.

GB200 Superchip е ключов компонент на системата DGX Grace Blackwell 200 (GB200), която съчетава 36 суперчипа GB200 (общо 72 графични процесора Blackwell и 36 процесора Grace) в една мощна система, разработена за най-сложните AI изчисления.

В допълнение към чиповете Blackwell и суперчипа GB200, Nvidia представи и новата си система за суперкомпютри, наречена DGX SuperPOD. Тя се състои от осем или повече отделни системи DGX GB200, свързани чрез високоскоростната мрежова технология Quantum InfiniBand на NVIDIA. Така DGX SuperPOD с 8 системи DGX GB200 ще има общо 576 графични процесора Blackwell. NVIDIA твърди, че в зависимост от нуждите на клиентите, системата може да поддържа десетки хиляди суперчипове GB200.

Amazon, Google, Microsoft и Oracle са сред организациите, които ще продават достъп до GB200 чрез облачни услуги, като Nvidia съобщи, че Amazon Web Services ще изгради сървърен клъстер с 20 000 чипа GB200.

Компанията твърди, че системата може да разгърне модели с до 27 трилиона параметри, което значително превъзхожда дори най-големите съществуващи, като например GPT-4, за който се твърди, че има 1,8 трилиона параметри.

Много изследователи на изкуствения интелект смятат, че колкото по-големи са моделите (повече параметри) и колкото повече данни са използвани за тяхното обучение, толкова по-голям е потенциалът за откриване на нови способности.

Последвайте ни в социалните мрежи – Facebook, Instagram, X и LinkedIn!

Споделете: