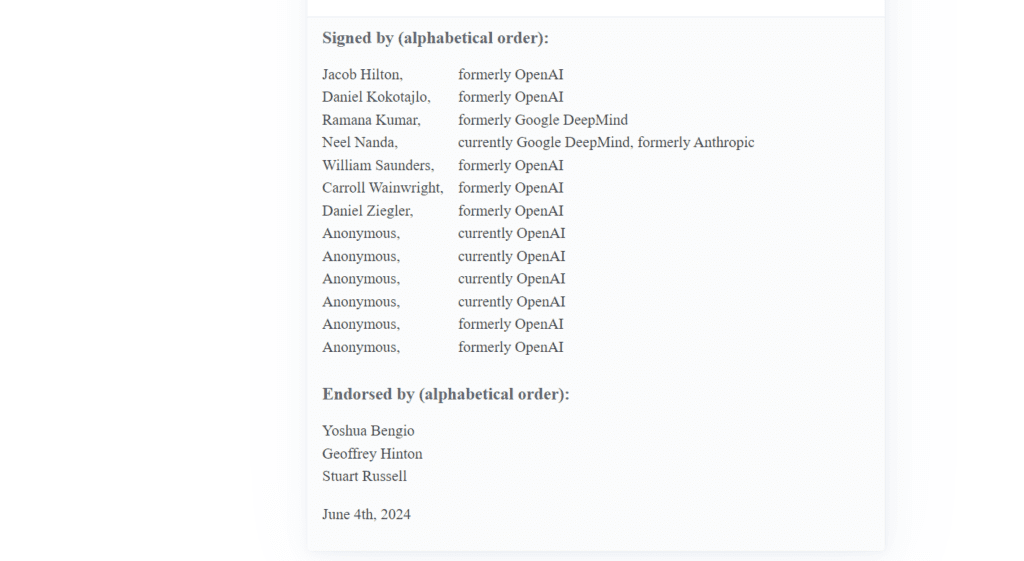

Група от настоящи и бивши служители на водещи компании за изкуствен интелект (AI), включително OpenAI, Google DeepMind и Anthropic – някои от тях анонимни – днес публикуваха отворено писмо, озаглавено „Право на предупреждение за напреднал изкуствен интелект“ (A Right to Warn about Advanced Artificial Intelligence).

Писмото, което е подкрепено и от световноизвестните експерти в областта Йошуа Бенгио, Джефри Хинтън и Стюарт Ръсел, подчертава спешната необходимост от по-голяма прозрачност и надеждна защита на хората, подаващи сигнали за нередности в индустрията.

Учените вярват, че „изкуственият интелект може да донесе безпрецедентни ползи за човечеството“, но същевременно се притесняват от сериозните рискове, които крие технологията. Те варират от „допълнително задълбочаване на съществуващите неравенства, през манипулация и дезинформация, до загуба на контрол върху автономни AI системи, които могат да унищожат човечеството“.

Самите компании признават рисковете, както и правителствата по света и други експерти в областта на изкуствения интелект

– предупреждават авторите на писмото.

Надяваме се, че тези рискове могат да бъдат адекватно намалени с достатъчно насоки от страна на научната общност, политиците и обществеността.

В писмото се посочва също, че „AI компаниите разполагат със солидна информация за възможностите и ограниченията на своите системи, която не е публична“. Те обаче имат „слаби задължения“ да споделят тази информация с правителствата и „не може да се разчита, че ще го направят доброволно“. Според авторите на писмото „тези компании имат сериозен финансов интерес да избегнат ефективен надзор“, а „обичайните структури за корпоративно управление не са достатъчни, за да променят това“.

Едно от основните искания на подписалите е свързано със защитата на лицата, сигнализиращи за нередности в индустрията.

Докато няма ефективен правителствен надзор над тези корпорации, настоящите и бившите служители са сред малкото хора, които могат да ги държат отговорни пред обществото

– се казва в писмото.

Някои от нас с основание се притесняват от различни форми на отмъщение, имайки предвид историята на подобни случаи в индустрията.

Авторите на писмото призовават компаниите, разработващи изкуствен интелект, да приемат четири основни принципа, които да гарантират безопасност и прозрачност:

- Компаниите не трябва да предприемат ответни мерки срещу служители, които повдигат въпроси, свързани с безопасността.

- Да се създаде проверим анонимен процес, чрез който служителите да изразяват своите опасения относно риска пред борда на директорите на компанията, регулаторните органи и независими организации.

- Компаниите трябва да подкрепят културата на открита критика и да позволяват на своите настоящи или бивши служителите да споделят публично опасенията си.

- Да не се да сключват или да прилагат споразумения, които не позволяват на служителите да обсъждат въпроси, свързани с рисковете от AI.

Освен това, в поредица от постове в X (Twitter), Даниел Кокотайло, бивш служител на OpenAI и един от подписалите писмото, обясни причините, поради които е решил да напусне компанията. Той заяви, че е „загубил доверие в способността на OpenAI да действа отговорно в стремежа си към създаване на изкуствен общ интелект (AGI)“.

Кокотайло твърди, че при напускането му през април са му били представени документи, съдържащи споразумение за конфиденциалност, целящо да му попречи да говори негативно за OpenAI, което той счита за неетично.

1/15: In April, I resigned from OpenAI after losing confidence that the company would behave responsibly in its attempt to build artificial general intelligence — “AI systems that are generally smarter than humans.” https://t.co/yzMKnZwros

— Daniel Kokotajlo (@DKokotajlo67142) June 4, 2024

Напускането на Кокотайло бе последвано от това на основателя и главен учен на OpenAI, д-р Иля Суцкевер, и изследователя в сферата на безопасността на AI, Ян Лейке. През последната година двамата ръководеха Superalignment екипа на OpenAI, който бе натоварен със задачата да разработва системи и процеси за управление на свръхинтелигентни AI модели, които са много по-умни от нас.

Лейке също изрази сериозни опасения относно приоритетите на OpenAI в серия от постове в X, в които написа:

Създаването на машини, които са по-умни от хората, е опасно по своята същност начинание. OpenAI поема огромна отговорност от името на цялото човечество.

Building smarter-than-human machines is an inherently dangerous endeavor.

— Jan Leike (@janleike) May 17, 2024

OpenAI is shouldering an enormous responsibility on behalf of all of humanity.

Последвайте ни в социалните мрежи – Facebook, Instagram, X и LinkedIn!

Споделете: