Леополд Ашенбренер, бивш изследовател на OpenAI, наскоро публикува провокативен доклад, озаглавен „Осъзнаване на ситуацията“, в който предлага своята гледна точка относно развитието на изкуствения интелект и потенциалните последици от създаването на изкуствен общ интелект (Artificial General Intelligence, AGI), кулминиращ в появата на свръхинтелигентност (Artificial Superintelligence, ASI).

Full series as PDF: https://t.co/sVfNoriSoW

— Leopold Aschenbrenner (@leopoldasch) June 4, 2024

Read online: https://t.co/YrKqmElMG0

Докладът, който е посветен на наскоро напусналия съосновател и главен учен на OpenAI д-р Иля Суцкевер, разглежда драматичните промени, които според Ашенбренер ще настъпят през следващите години в глобален мащаб.

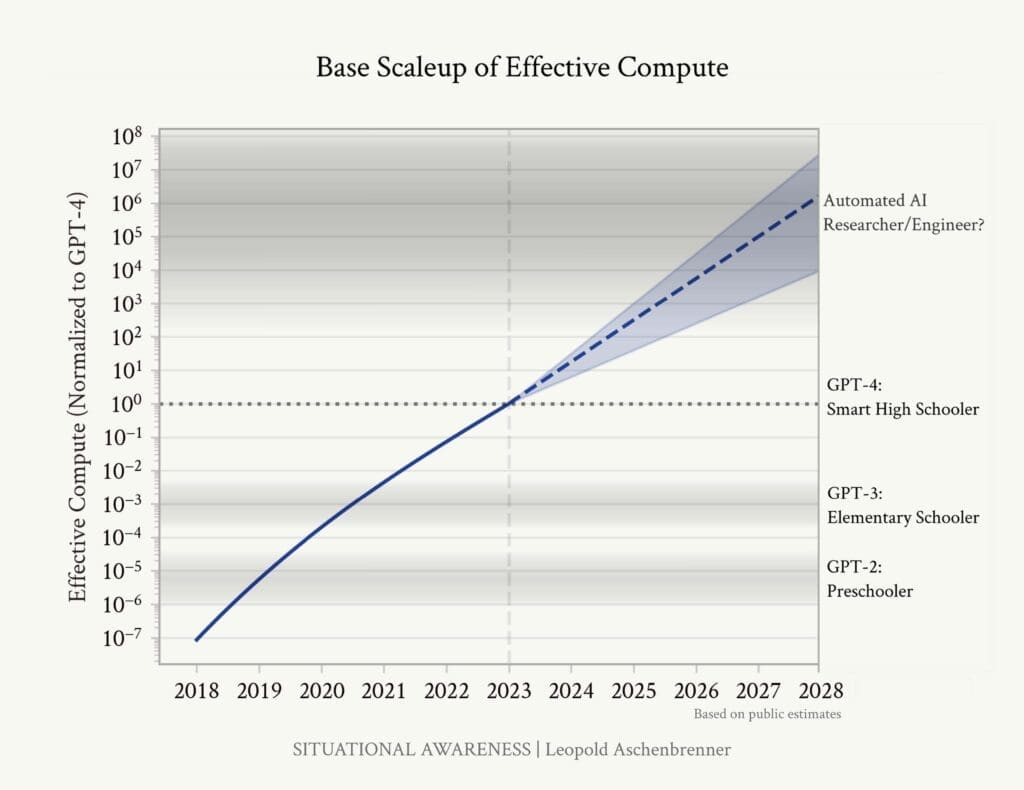

Според него „до края на десетилетието ще бъдат изградени компютърни клъстери на стойност трилиони долари“, а това от своя страна ще доведе до “създаването на машини много по умни от нас“.

Състезанието за изкуствен общ интелект (AGI) започна. Разработваме машини, които могат да мислят и разсъждават. До 2025/26 г. тези машини ще надминат много от хората с висше образование

– пише Ашенбренер.

До края на десетилетието те ще бъдат по-умни от вас или от мен; ще достигнем свръхинтелигентност в истинския смисъл на думата.

Според него, когато веднъж създадем AGI, „няма да имаме само един AGI“, а „милиони от тях“. Той предполага, че тези системи, работещи паралелно, ще могат да вършат неговата работа и тази на бившите му колеги от OpenAI, но с тази разлика, че ще бъдат „100 000 пъти повече“, ще бъдат по-бързи и ще работят денонощно върху алгоритмични пробиви. По думите му, тези AI учени ще могат да прочетат всяка една статия за машинно обучение, написана някога, ще могат да обмислят задълбочено всеки един предишен експеримент, проведен в лабораторията, ще се учат паралелно от всяко свое копие и бързо ще натрупат еквивалента на хиляди години опит. „Те ще могат да развият много по-дълбоки интуиции за машинното обучение от всеки човек“.

Автоматизираните изследвания в областта на изкуствения интелект вероятно биха могли да компресират едно човешко десетилетие на алгоритмичен напредък за по-малко от година (и това изглежда консервативно)

– отбелязва Ашенбренер.

Ашенбренер подчертава, че след като тези технологии бъдат приложени във всички области на науката, технологиите и икономиката, „светът ще се промени коренно“, нещо, което той нарича „експлозия на интелигентност“. Всичко ще започне да се случва изключително бързо.

Преди да се усетим, ще имаме свръхинтелигентност – AI системи, много по-умни от хората, способни на ново, творческо и сложно поведение, което дори не бихме могли да разберем – може би дори малка цивилизация, милиарди от тях

– пише той.

Периодът непосредствено след появата на свръхинтелигентността, според него, „ще бъде един от най-нестабилните, напрегнати, опасни и диви периоди в човешката история“. Той предупреждава, че именно тогава съществува „реална възможност да изгубим контрол“ над тези AI системи.

Свръхчовешкият, извънземен свръхразум е нова игра и тя е страшна

– твърди Ашенбренер.

Той смята, че свръхинтелигентните AI системи ще осигурят както икономическо, така и военно предимство на държавите, които ги притежават, а тази „надпреварата ще бъде решаващ фактор за определяне на бъдещия баланс на силите“.

Разработваме най-мощното оръжие, което човечеството някога е създавало

– предупреждава Ашенбренер.

Появата на свръхинтелигентността ще ни постави в ситуация, невиждана от началото на атомната ера: тези, които я притежават, ще имат пълно господство над тези, които не я притежават.

В момента в света има може би няколкостотин души, които си дават сметка за това, което ще ни сполети, които разбират колко луди ще станат нещата, които са наясно със ситуацията.

Последвайте ни в социалните мрежи – Facebook, Instagram, X и LinkedIn!

Споделете: