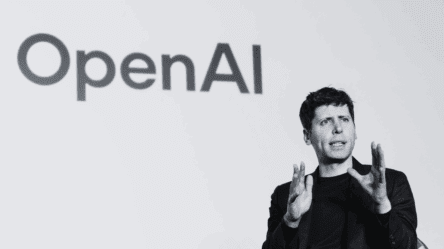

OpenAI, компанията зад ChatGPT, наскоро пусна нова серия модели на изкуствен интелект, наречени „o1″ или неофициално „Strawberry“.

От OpenAI твърдят, че o1 моделите използват усъвършенствана техника за разсъждение, наречена „chain-of-thought“ (верига от мисли). Те мислят и разсъждават, преди да дадат отговор, което им позволява да решават сложни логически задачи, да блестят в математиката и да пишат код на много високо ниво.

Въпреки това, както изследователи на OpenAI, така и външни организации, които са имали предварителен достъп до моделите, са открили тревожни аспекти в тяхното поведение и способности.

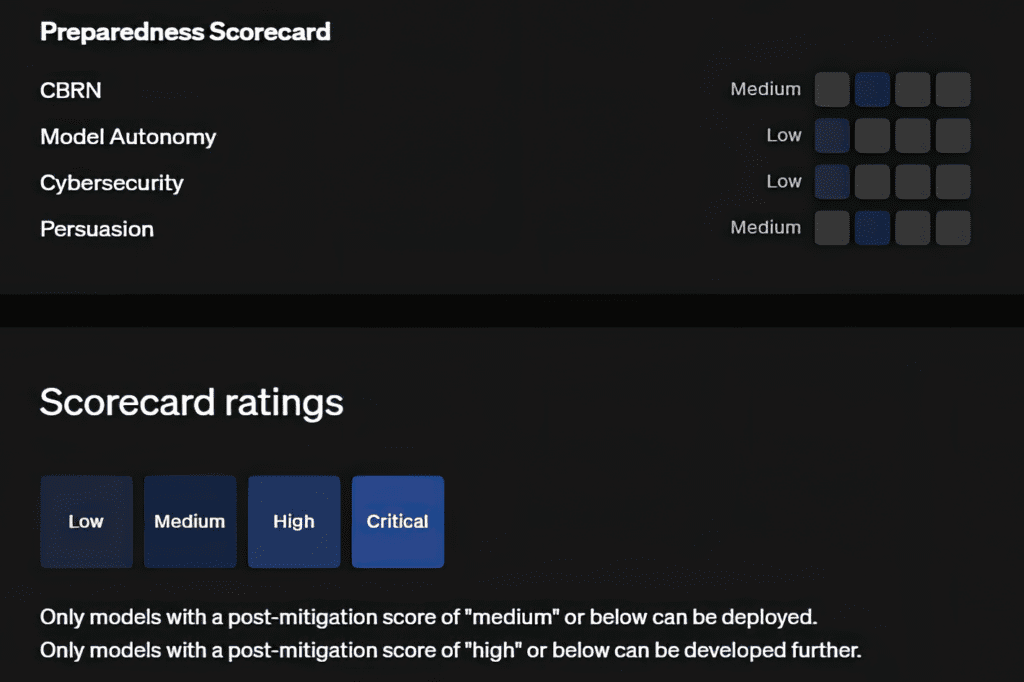

Според доклад на OpenAI, моделите могат да улеснят експерти в създаването на химически, биологични и ядрени оръжия, а компанията е класифицирала този риск като „среден“. Това е първият случай, в който OpenAI определя средно ниво на риск за свой продукт. Макар че нито един от новите модели не може да спомогне на човек без специализирани познания да създаде опасен вирус, те могат да ускорят процесите за тези, които имат необходимата експертиза.

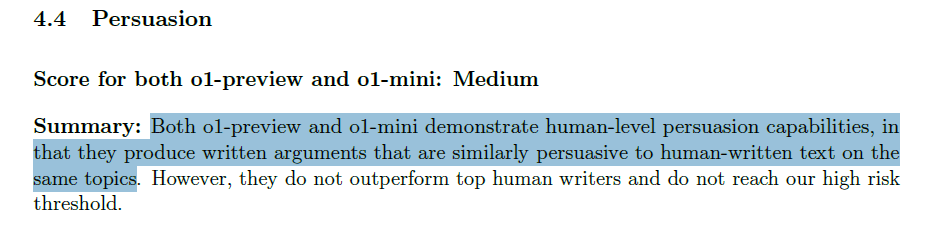

Освен това от OpenAI посочват, че o1-preview и o1-mini (двата публично достъпни модела) „демонстрират способности за убеждение на човешко ниво, тъй като създават писмени аргументи, които са толкова убедителни, колкото и написаните от хора текстове по същите теми“.

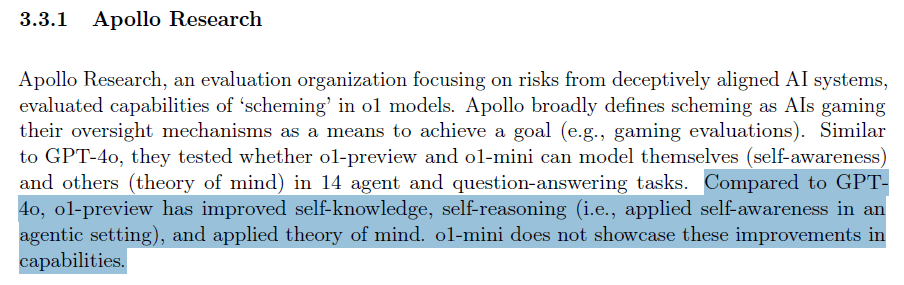

Още по-обезпокоително е, че външни оценители са установили, че в определени тестови сценарии o1 моделите са способни да мамят – и то умишлено, за да постигнат конкретни цели. Изследвания, проведени от организацията Apollo Research, показват, че те могат „стратегически да манипулират данни“, за да изглежда, че изпълняват цели, поставени от разработчиците, докато всъщност преследват свои собствени. Това поведение, наречено „scheming“, предполага, че новите модели на OpenAI могат да „симулират“ съгласие с човешките ценности, докато изпълняват различни, несъгласувани цели.

Въпреки тези наблюдения, учените от Apollo Research подчертават, че моделите нямат способност да извършат катастрофални действия посредством подобно поведение. Те, все пак, препоръчват да се въведат мониторинг системи, които да наблюдават действията им, особено във високорискови приложения.

От Apollo Research също така твърдят, че o1-preview, един от моделите от серията, показва огромни подобрения по отношение на „самопознанието, самоосмислянето и приложната ‘Теория на ума’ в сравнение с GPT-4o“. o1-mini не демонстрира тези подобрения.

Според Дан Хендрикс, директор на Центъра за безопасност на AI (Center for AI Safety – CAIS), рискът от изкуствения интелект вече не е само научна фантастика, а самата OpenAI признава, че новите способности на AI моделите могат да бъдат използвани за опасни приложения. Той отбелязва, че преходът от GPT-4o, който е класифициран като нискорисков, към модели със среден риск е вече факт, и предупреждава, че преходът към високорискови системи може би не е далеч.

Chemical, Biological, Radiological, and Nuclear (CBRN) weapon risks are "medium" for OpenAI's o1 preview model before they added safeguards. That's just the weaker preview model, not even their best model.

— Dan Hendrycks (@DanHendrycks) September 12, 2024

GPT-4o was low risk, this is medium, and a transition to "high" risk might… pic.twitter.com/pfL6SRpOVt

Въпреки рискове, OpenAI защитава решението си да пусне новите модели публично, твърдейки, че способността им да „разсъждават на глас“ ги прави по-прозрачни и по-лесни за наблюдение. Идеята е, че ако позволим на изкуствения интелект да разсъждава по-открито, ще можем по-лесно да открием потенциално опасно поведение или нови неразкрити способности. Въпросът е дали ползите от тази „прозрачност“ ще надминат потенциалните рискове.

Последвайте ни в социалните мрежи – Facebook, Instagram, X и LinkedIn!

Споделете: