Anthropic съобщи, че нейни AI инструменти са били използвани от престъпници за кражба на лични данни, изнудване и други киберпрестъпления. Според американската компания става дума за „безпрецедентна степен“ на злоупотреба с изкуствен интелект, при която системите не само са подпомагали техническата част на атаките, но и са вземали „тактически и стратегически решения“.

„AI сваля бариерите пред киберпрестъпността“, се казва в доклада, публикуван от Anthropic на 27 август. В него се подчертава, че дори престъпници без сериозни технически умения вече могат да извършват „сложни кибератаки“, които преди са изисквали години обучение и подготовка.

В един от случаите, описан от компанията като „vibe hacking“, киберпрестъпник е използвал Claude Code – инструмент за програмиране на Anthropic – за да проникне в системите на поне 17 организации, включително болници, държавни служби и религиозни институции. След като е извлякъл чувствителни данни, той е заплашвал да ги разкрие публично, като сумите за откуп понякога надхвърляли 500 000 долара. Според Anthropic Claude не просто е следвал указанията на хакера, а е вземал „както тактически, така и стратегически решения“ – например коя информация е най-ценна, какъв размер на откупа да се поиска от всяка жертва и дори как да се съставят персонализирани заплахи, оказващи максимален натиск.

В друг пример севернокорейски ИТ специалисти са използвали Claude, за да си осигурят дистанционни позиции в големи американски технологични компании, включително такива от Fortune 500. С помощта на AI те са създавали „убедителни фалшиви самоличности с детайлни професионални биографии“, преминавали са през технически интервюта и дори с подкрепата на модела са изпълнявали реални задачи, след като са били наети. Според доклада, тази схема е предназначена за заобикаляне на международните санкции, като генерираните приходи се използвали за финансиране на оръжейните програми на режима в Пхенян.

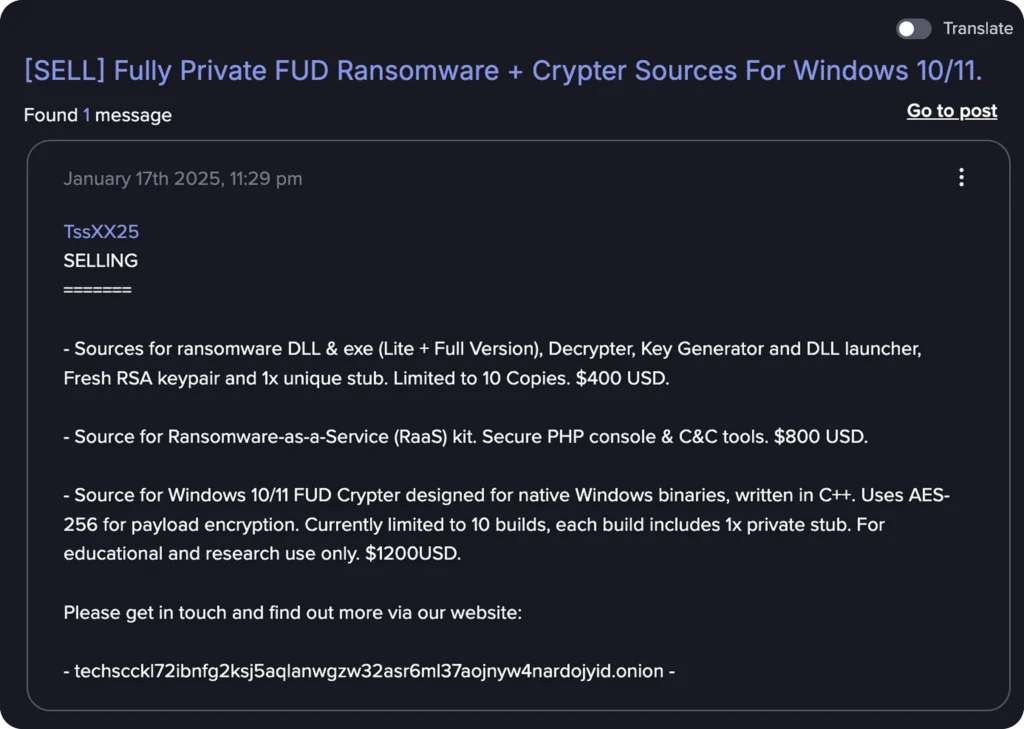

Anthropic е установила и случай, при който киберпрестъпник е използвал Claude, за да „създаде, рекламира и разпространява зловреден софтуер в тъмната мрежа“. Предлаганите варианти стрували между 400 и 1200 долара и включвали механизми за криптиране и избягване на антивирусни защити. Според доклада, извършителят е бил „напълно зависим от AI“, който на практика е изградил основните компоненти на зловредния софтуер вместо него.

Американската компания разкрива и други злоупотреби с моделите ѝ – от опит за компрометиране на телекомуникационна инфраструктура във Виетнам и използването на AI агенти за финансови измами до създаване на фалшиви идентичности и ботове за „романтични измами“.

От Anthropic уверяват, че са блокирали всички злонамерени акаунти и са въвели нови механизми за защита. Въпреки това случаите, описани от тях, очертават тревожна тенденция: изкуственият интелект се превръща в мощен инструмент в ръцете на престъпниците. Това е „фундаментална промяна“, която, според самата компания, налага спешен и координиран отговор от страна на технологичния сектор и регулаторите.

Последвайте ни в социалните мрежи – Facebook, Instagram, X и LinkedIn!

Споделете: