По повод една година от стартирането на Copilot, Microsoft обяви интеграцията на най-новия модел на OpenAI, GPT-4 Turbo, в AI асистента. Това обещава значително да улесни потребителите в справянето с по-дълги и по-сложни задачи.

GPT-4 Turbo, който беше обявен на конференцията DevDay на OpenAI, има контекстуален прозорец от 128 000 токена, което означава, че може да „вижда“ и обработва по-голям обем данни. „Токен” в този контекст означава най-малката единица информация, която моделът може да обработва, като например дума или част от дума. Предишното поколение позволяваше обработка на текстови данни до 50 страници, докато GPT-4 Turbo обработва до 300 страници. В момента интеграцията се тества от избрани потребители, като по-широкото ѝ разпространение се очаква през следващите седмици.

Паралелно с GPT-4 Turbo, в Copilot ще бъде интегриран и DALL-E 3 – генераторът на изображения на OpenAI.

Microsoft също така стартира „Deep Search“ – нова експериментална функция за своята търсачка Bing, която ще използва GPT-4, за да предоставя по-изчерпателни и релевантни резултати при сложни заявки за търсене от потребителите.

Според официалното изявление на Microsoft, „Deep Search“ цели да адресира често срещан проблем в процеса на търсене – неспособността на традиционните търсачки адекватно да интерпретират специфични и нюансирани потребителски въпроси. В много случаи, те се оказват неефективни в разбирането на сложните заявки, което води до предоставянето на непълни или нерелевантни отговори. Deep Search обещава да преодолее тези ограничения, като използва GPT-4 за по-дълбок и прецизен анализ на потребителските заявки.

Важно е да се отбележи, че търсенето с „Deep Search“ ще отнема до 30 секунди в сравнение с мигновенните отговори от традиционната търсачка на Bing. Поради тази причина потребителите могат да избират дали да го използват или не. Microsoft отбелязва, че функцията не е заместител на съществуващото уеб търсене в Bing, а е подобрение, което позволява по-задълбочено проучване в мрежата.

Компанията също така планира да въведе нова функция, наречена „Multi-Modal with Search Grounding„, в Bing. Тази функция, базирана на мултимодалните възможности на GPT-4, позволява на изкуствения интелект да анализира както текст, така и изображения. Например, потребителите могат да качат снимка да задават въпроси по нея.

Подобно на ChatGPT, Microsoft Copilot също ще получи „Code Interpreter„. Функцията ще даде възможност на потребителите да изпълняват сложни задачи като анализ на данни, визуализация, математика и, разбира се, кодиране. В момента Code Interpreter е в бета-версия, като широкото му разпространение се очаква в близко бъдеще.

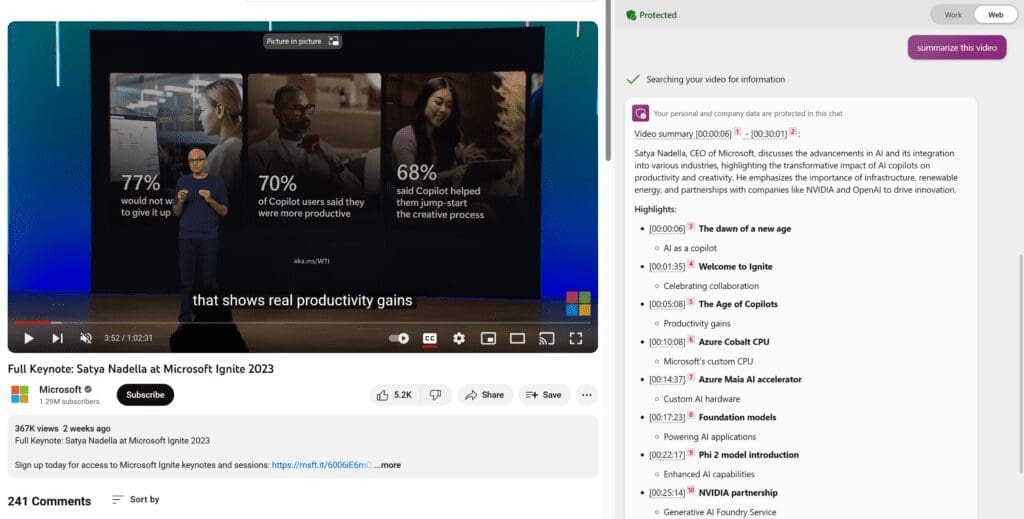

И на последно място, Copilot в Edge, подобно на Google Bard, вече може да обобщава видеоклипове.

Последвайте ни в социалните мрежи – Facebook, Instagram, X и LinkedIn!

Споделете: