Понятието „контекстен прозорец“ при големите езикови модели (LLM) е основен елемент в разбирането на начина, по който системи като ChatGPT на OpenAI или Bard на Google обработват информация.

Преди да се запознаем с него, е важно да разберем какво представляват големите езикови модели. Това са огромни невронни мрежи, разработени на принципа на нашия биологичен мозък. Те са обучени на огромни набори данни от интернет, книги и други източници. В процеса на обучение моделите научават закономерностите в тези данни. Това им позволява да прогнозират с висока степен на точност вероятността определена дума или фраза да последва в даден контекст. Резултатът е системи, способни да генерират и разбират човешки език със забележителна прецизност.

Сред най-известните големи езикови модели са GPT на OpenAI, фамилията Gemini от Google, както и LLaMA на Meta.

Контекстният прозорец при езикови модели е механизъм, който определя обхвата на текста, върху който моделът се фокусира, когато обработва информация, формулира отговори или извършва други задачи свързани с езиковото моделиране.

Можем да си го представим като четене на книга, но през малък прозорец, който ни позволява да виждаме само няколко изречения във всеки един даден момент. Всеки път, когато прочетем ново изречение, предходното е забравено и заменено с новото. Аналогично, моделите обработват информацията, която е налична в техния ограничен контекстен прозорец.

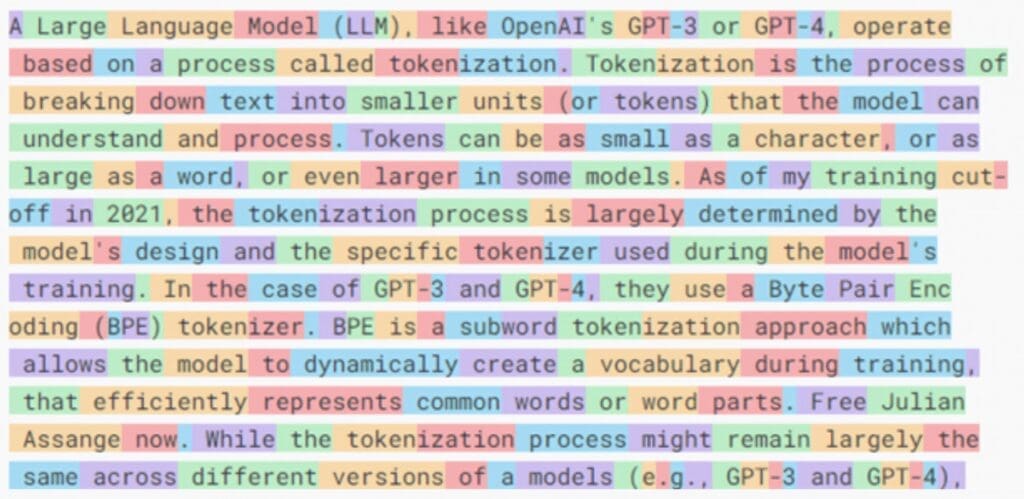

С други думи, контекстният прозорец определя колко текст може да „види“ и обработи модела във всеки един даден момент. Тук е важно да отбележим, че текстът, с който работи моделът, е разделен на единици, наречени токени (tokens).

Токените могат да бъдат толкова малки, колкото един символ, или толкова дълги, колкото една дума. Броят на токените, които моделът може да обработва едновременно, се определя от размера на неговия контекстен прозорец. По-големите контекстни прозорци позволяват на модела да възприема повече текст, което води до по-дълбоко тълкуване и по-добре съобразени с контекста отговори.

Например стандартният ChatGPT на OpenAI има контекстен прозорец от 8000 токена, а разширената версия – 32 000. Последният модел GPT-4 Turbo има контекстен прозорец от 128 000 токена, което се равнява на 300 страници текст. Докато пък моделът Claude 2.1 на Anthropic има още по-голям контекстен прозорец от 200 000 токена.

Разширяването на размера на контекстния прозорец при езиковите модеи е въпрос на баланс. От една страна, по-големият прозорец подобрява разбирането на модела и способността му да генерира подходящ текст. От друга страна, той значително увеличава изчислителната мощност и необходимото време за обработка. Освен това с нарастването на прозореца моделът може да се затрудни да поддържа ясна представа за контекста поради огромния обем информация, която трябва да вземе предвид.

Понятието „контекстен прозорец“ се простира отвъд обработката на текст. В мултимодалните модели, като например новите модели Gemini на Google, които обработват различни видове данни, като изображения, видео и аудио, контекстуалният прозорец може да се отнася до няколко кадъра или части от изображение, които моделът може да анализира едновременно.

В заключение, тъй като езиковите модели се развиват постоянно и то с невероятна скорост, оптимизацията на контекстните прозорци на моделите се очертава да бъде основен приоритет за технологичните компании и изследователските лаборатории. Целта е да се намери идеалният баланс между дълбочината на анализа и изчислителната мощ. Процесът е от решаващо значение не само за обработката на текст, но и за други видове данни, като например изображения, аудио и видео, които са ключови за разширяване на възможностите на мултимодалните AI модели.

Последвайте ни в социалните мрежи – Facebook, Instagram, X и LinkedIn!

Можете също така да ни намерите и последвате и в Google News Showcase.

Споделете: