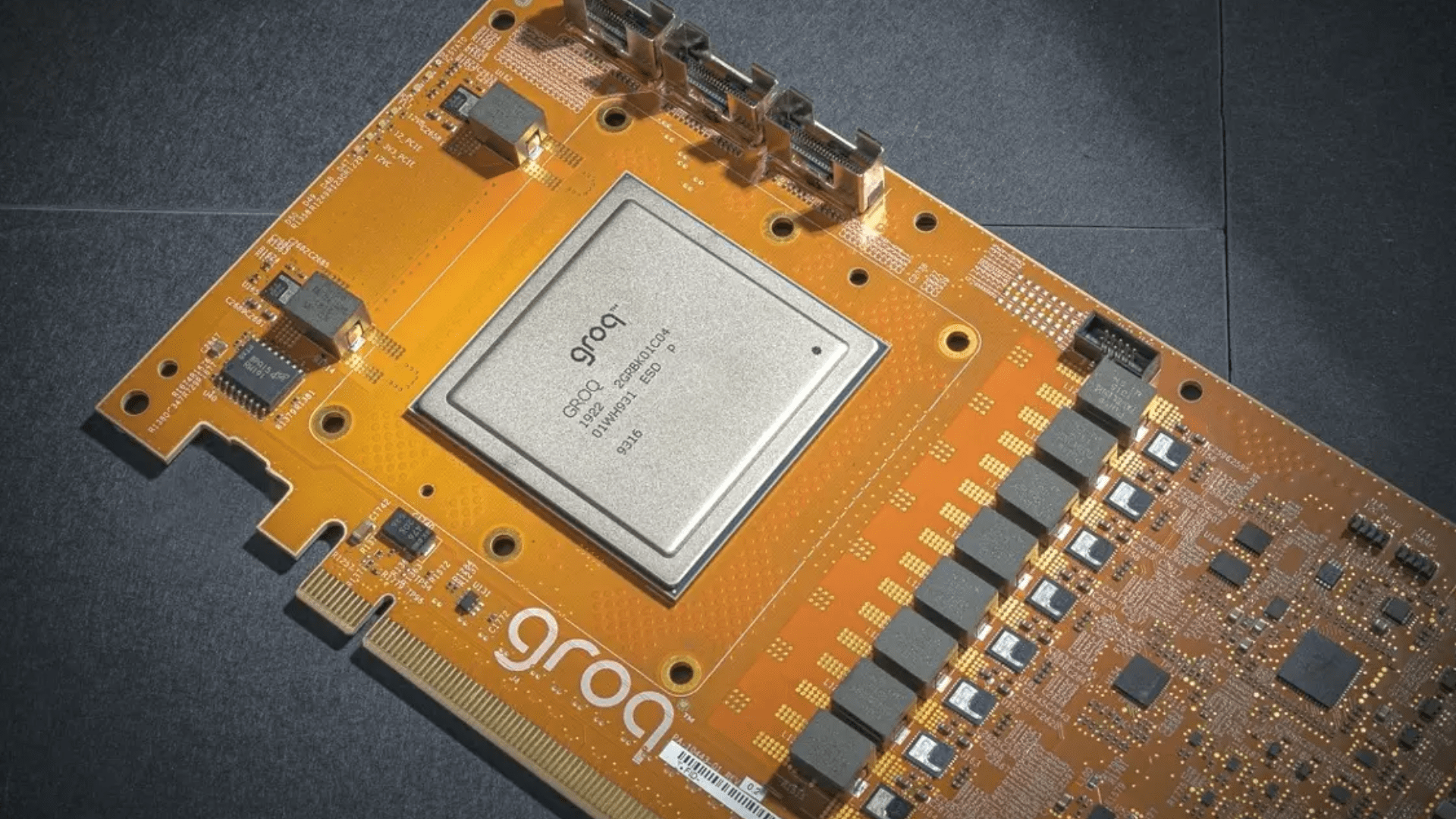

Groq, американска компания, съоснована през 2016 г. от Джонатан Рос, бивш служител на Google и ключова фигура в разработването на Tensor Processing Unit (TPU), представи нов вид чипове за изкуствен интелект, наречени Language Processing Unit™ (LPU) или Language Inference Engine™.

Тези чипове са специално разработени за изпълнение на езикови модели и осигуряват скорост до невероятните 500 токена в секунда. За сравнение, според проучване, проведено в края на миналата година, Gemini Pro на Google и GPT-3.5 на OpenAI обработват между 30 и 50 токена в секунда.

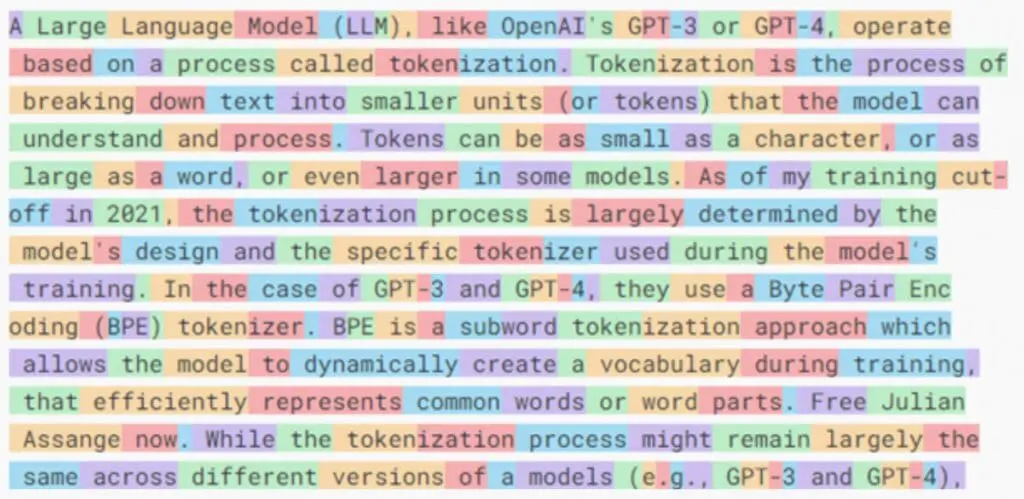

Токените в контекста на езиковите модели могат да бъдат думи, части от думи или дори отделни символи, а обработката им е от основно значение за генерирането и разбирането на естествения език от изкуствения интелект.

Try https://t.co/tfPlxzUDkZ now

— @levelsio (@levelsio) February 19, 2024

Hyperfast LLM running on custom built GPUs

Answers in miliseconds, not seconds

How? 🤯 pic.twitter.com/c0dOT90Her

LPU използва така наречената „тензорна поточна архитектура“, която според компанията е проектирана за по-добра производителност, ефективност, скорост и прецизност.

Тази технология има за цел да преодолее ограниченията на традиционните CPU и GPU при обработката на интензивните изчислителни задачи, свързани с изпълнението на големи езикови модели, като обещава по-бърз извод и по-ниска консумация на енергия.

Според стартъпа, за разлика от традиционните графични процесори (GPU), чипът предлага опростена архитектура, която позволява постоянна латентност и пропускателна способност.

Wow, that's a lot of tweets tonight! FAQs responses.

— Groq Inc (@GroqInc) February 19, 2024

• We're faster because we designed our chip & systems

• It's an LPU, Language Processing Unit (not a GPU)

• We use open-source models, but we don't train them

• We are increasing access capacity weekly, stay tuned pic.twitter.com/nFlFXETKUP

LPU Inference Engine™ на Groq е проектиран така, че да превъзмогне двете основни пречки по отношение на големите езикови модели (LLM): количеството изчисления и пропускателната способност на паметта.

– посочва компанията в своя уебсайт.

LPU има по-голям изчислителен капацитет от GPU и CPU по отношение на големите изикови модели. Това води до намаляване на времето за изчисление на всяка дума, позволявайки генерирането на последователност от текст много по-бързо.

Подходът на Groq за ускоряване на AI изчисленията включва не само хардуер, но и стратегия, ориентирана към софтуера, която позволява на множество чипове да работят ефективно в синхрон.

Производителността на LPU Inference Engine на Groq е била обект на външна независима оценка от ArtificialAnalysis.ai, като резултатите сочат, че системата на компанията е постигнала зашеметяващите 430 токена/сек на Mixtral 8x7B и 240 на Llama 2 70b.

We have some more recent benchmarks of Groq performance too: 430 tokens/s on Mixtral 8x7B and 240 on Llama 2 70b. Seeing sustained performance over time as wellhttps://t.co/qVxIfA2ODA pic.twitter.com/esIDkYl44C

— ArtificialAnalysis.ai (@ArtificialAnlys) February 19, 2024

Системите на Groq поддържат широко разпространени рамки за машинно обучение, а компанията предлага и API за модели с отворен код, като например Mixtral на френската компания Mistral.

Засега обаче LPU чиповете работят само за изпълнение на AI модели. За обучението им компаниите все още се нуждаят от графични процесори от Nvidia или др.

Можете да тествате скоростта на Groq при изпълнение на отворени езикови модели (например Mixtral или Llama 2) тук.

Последвайте ни в социалните мрежи – Facebook, Instagram, X и LinkedIn!

Споделете: