В блог пост от вчера (18 декември) създателят на ChatGPT, OpenAI, очерта стратегически подход за справяне с потенциалните опасности, които крие изкуственият интелект, включително риска от предоставяне на информация на киберпрестъпниците за това как да създават химически и биологични оръжия.

Компанията сформира екип, наречен „Подготвеност“ (Preparedness), който ще бъде ръководен от Александър Мадри, директор на Центъра за разгърнато машинно обучение на Масачузетския технологичен институт, и ще включва изследователи на изкуствения интелект, компютърни специалисти, експерти по национална сигурност и политически експерти.

Медри беше един от лидерите на OpenAI, които подадоха оставка, когато Алтман беше уволнен от борда през ноември. Той се върна в компанията след възстановяването на Алтман.

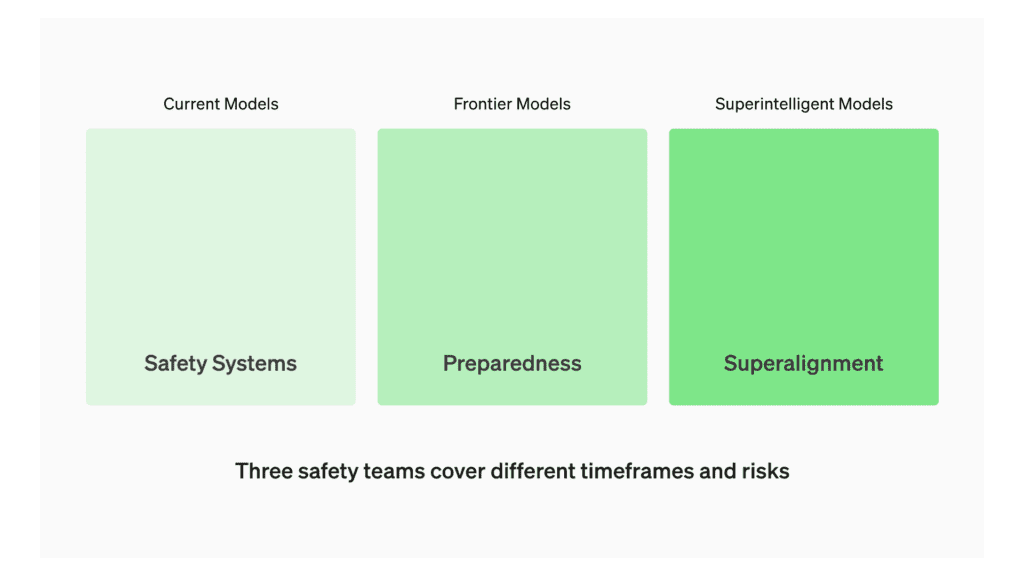

Подходът на OpenAI към безопасността на изкуствения интелект е разделен на три отделни екипа: „Safety Systems„, „Preparedness„, and „Superalignment„. Екипът „Safety Systems“ отговаря за управлението на рисковете, свързани с модели в производство като ChatGPT, екипът „Preparedness“ ще се фокусира върху модели, които все още са в процес на разработване, а екипът „Superalignment“ разглежда теоретичните аспекти, свързани със свръхинтелигентните бъдещи модели. Всеки екип има собствен набор от отговорности и цели.

Като част от този подход екипът „Preparedness“ ще извършва оценки и ще разработва „скали за оценка“ на моделите, които ще се актуализират постоянно.

Нашата цел е да изследваме конкретните граници на това, което е опасно, за да можем ефективно да се справим с установените рискове

– посочват от OpenAI.

Рисковете ще бъдат категоризирани в четири основни области – киберсигурност, CBRN (химически, биологични, радиологични и ядрени заплахи), убеждение (например дезинформация) и автономност. Всяка категория ще се оценява на четири нива на риск – ниско, средно, високо и критично. Моделите, оценени като „високорискови„, няма да бъдат внедрени, а тези с „критични“ рискове няма да бъдат допълнително разработвани.

Този технически процес е от решаващо значение за информиране на ръководството на OpenAI при вземането на решения за безопасно разработване и внедряване на модели

– пишат от компанията.

Екипът ще извършва и постоянни проучвания, за да тества натиска върху бизнеса и корпоративната среда. Компанията също така ще провежда външни одити и непрекъснато ще преоценява моделите.

И накрая, OpenAI ще използва получените резултати и експертни становища, за да следи за злоупотреби в реалния свят.

Инвестираме в разработването и прилагането на строги оценки на възможностите на моделите, както и в прогнозни анализи за по-добро откриване на възникващи рискове. По-специално искаме да изместим дискусиите за рисковете отвъд хипотетичните сценарии към конкретни оценки и прогнози, основани на данни. Също така искаме да погледнем отвъд това, което се случва днес, за да предвидим какво предстои. Това е от решаващо значение за нашата мисия, така че ангажираме най-добрите си технически таланти с тази задача

– пишат от OpenAI.

Последвайте ни в социалните мрежи – Facebook, Instagram, X и LinkedIn!

Можете също така да ни намерите и последвате и в Google News Showcase.

Споделете: